我们一般网站都是希望搜索引擎能够尽量多滴收录我们的网站,当你看到文章标题的时候你是不是怀疑诺言写错了呢?其实诺言并没有写错,诺言要写的就是如何防止搜索引擎收录网站,为什么要写这个教程呢?大家自己都清楚,哈哈,就不需要诺言直接说出来了吧,下面就进入正题啦。

如何防止搜索引擎收录网站

robots.txt文件,是屏蔽搜索引擎蜘蛛爬取网站!

Disallow: /user Disallow: /lib Disallow: /admin Disallow: /vendor User-agent: Baiduspider Disallow: / User-agent: Sosospider Disallow: / User-agent: sogou spider Disallow: / User-agent: YodaoBot Disallow: /

这里只是把百度、搜狗、有道、SOSO屏蔽了。如果有需要可以去这里生成robots内容:站长工具

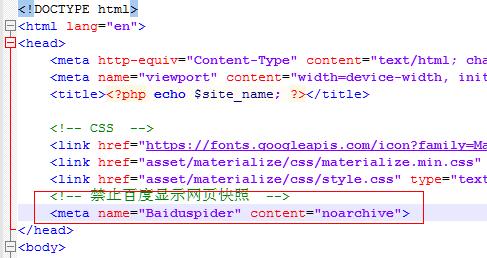

然后在header.php文件<head>里面加上一个防止百度收录快照的代码:

<meta name="Baiduspider" content="noarchive">

但是百度不一定遵守robots规则,可能依然收录,那就用下面的终极办法!

还有一个终极方法,如果你用的是Nginx,以lnmp为例,那就在/usr/local/nginx/conf/vhost文件夹中找到你的域名配置文件,比如:www.baidu.com.conf

然后在里面插入以下代码:

if ($http_user_agent ~* (baiduspider|googlebot|soso|bing|sogou|yahoo|sohu-search|yodao|YoudaoBot|robozilla|msnbot|MJ12bot|NHN|Twiceler)) {

return 403;

}

然后保存并上传替换,然后ssh链接vps输入lnmp nginx restart(如果提示出错请根据错误修改!)这时候去站长工具测试一下效果,看是不是返回403代码。

诺言暂时知道的就这几种方法,如果你有什么好的方法,请教教诺言哈!